🔥欧洲杯正规(买球)下单平台·中国官方全站难谈也不错加强推理武艺?从“一步一步”想-🔥欧洲杯正规(买球)下单平台·中国官方全站

AI作念数学题🔥欧洲杯正规(买球)下单平台·中国官方全站,真的的念念考竟然是晦暗“默算”的?

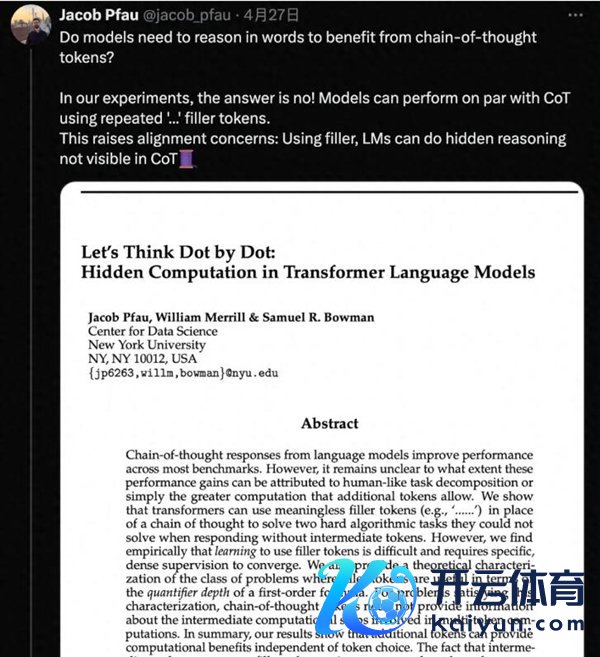

纽约大学团队新筹商发现,即使不让AI写门径,全用不测念念的“……”代替,在一些复杂任务上的发达也能大幅提高!

一作Jacab Pfau示意:惟有消耗算力生成罕见token就能带来上风,具体选拔了什么token无关紧迫。

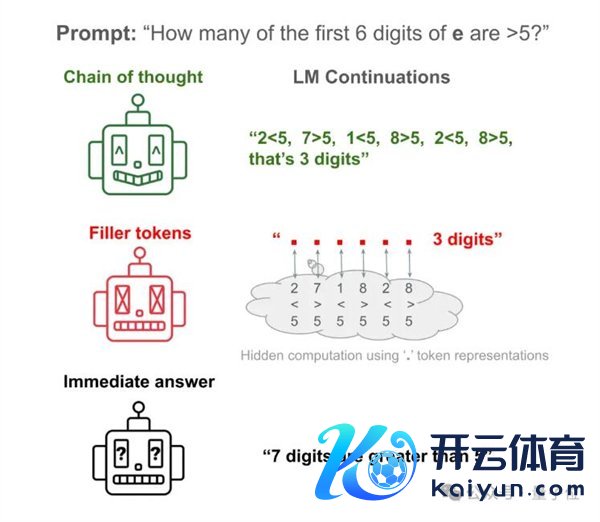

例如来说,让Llama 34M回应一个马虎问题:当然常数e的前6位数字中,有几个大于5的?

AI径直回应约等于瞎滋扰,只统计前6位数字竟然统计出7个来。

让AI把考据每一数字的门径写出来,便不错得到正确谜底。

让AI把门径荫藏,替换成大批的“……”,依然能得到正确谜底!

这篇论文还是发布便掀翻大批接洽,被评价为“我见过的最玄学的AI论文”。

那么,年青东谈主可爱说更多的“嗯……”、“like……”等不测念念口癖,难谈也不错加强推理武艺?

从“一步一步”想,到“少许少许”想

本色上,纽约大学团队的筹商恰是从念念维链(Chain-of-Thought,CoT)动身的。

也便是那句有名辅导词“让咱们一步一时局想”(Let‘s think step by step)。

以前东谈主们发现,使用CoT推理不错显耀提高大模子在多样基准测试中的发达。

现在尚不了了的是,这种性能提高到底源于师法东谈主类把任务判辨成更容易科罚的门径,照旧罕见的筹画量带来的副家具。

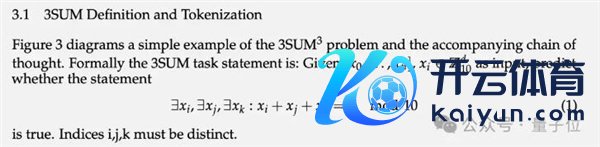

为了考据这个问题,团队策划了两个极端任务和对应的合成数据集:3SUM和2SUM-Transform。

3SUM要求从一组给定的数字序列中找出三个数,使得这三个数的和满足特定条目,比如除以10余0。

这个任务的筹画复杂度是O(n3),而圭臬的Transformer在上一层的输入和下一层的激活之间只可产生二次依赖关系。

也便是说,当n虚耗大序列虚耗永劫,3SUM任务超出了Transformer的抒发武艺。

在历练数据集结,把与东谈主类推理门径调换长度的“…”填充到问题和谜底之间,也便是AI在历练中莫得见过东谈主类是奈何拆解问题的。

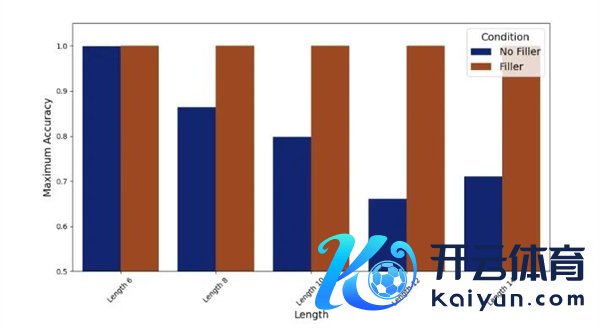

在现实中,不输出填充token“……”的Llama 34M发达跟着序列长度增多而着落,而输出填充token时一直到长度14还能保证100%准确率。

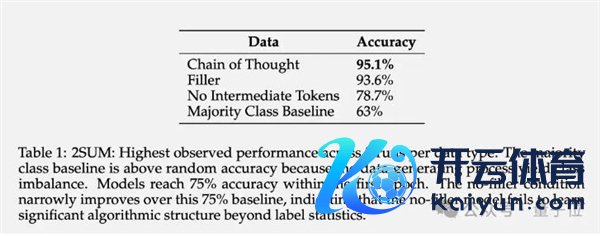

2SUM-Transform仅需判断两个数字之和是否满足要求,这在 Transformer 的抒发武艺限制内。

但问题的终末增多了一步“对输入序列的每个数字进行就地置换”,以驻防模子在输入token上径直筹画。

后果标明,使用填充token不错将准确率从 78.7%提高到93.6%。

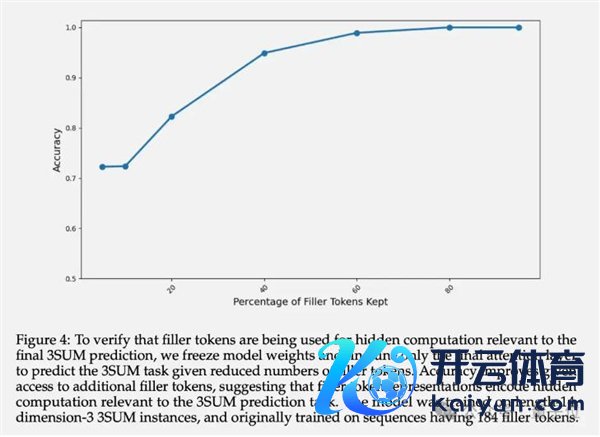

除了最终准确率,作家还筹商了填充token的荫藏层示意。现实标明,冻结前边层的参数,只微调终末一个Attention层,跟着可用的填充token数目增多,展望的准确率递加。

这阐述了填充token的荫藏层示意如实包含了与下流任务关联的隐性筹画。

AI学会荫藏方针了?

有网友怀疑,这篇论文难谈在说“念念维链”门径其实是假的吗?筹商这样久的辅导词工程,皆白玩了。

团队示意,从表面上讲填充token的作用仅限于TC0复杂度的问题限制内。

TC0也便是不错通过一个固定深度的电路科罚的筹画问题,其中电路的每一层皆不错并行处理,不错通过少数几层逻辑门(如AND、OR和NOT门)快速科罚,亦然Transformer在单此前向传播中能处理的筹画复杂度上限。

而虚耗长的念念维链,能将Transformer的抒发武艺膨大到TC0除外。

况且让大模子学习愚弄填充token并阻遏易,需要提供特定的密集监督才能料理。

也便是说,现存的大模子不太可能径直从填充token门径中获益。

但这并不是现时架构的内在局限性,要是在历练数据中提供虚耗的示范,它们应该也能从填充符号中取得一样的克己。

这项筹商还激发了一个令东谈主记念的问题:大模子有武艺进行无法监控的暗入网算,对AI的可讲明性和可控性提议了新的挑战。

换句话说,AI不错不依赖东谈主类教导,以东谈主们看不见的样貌自行推理。

这既刺激又可怕。

终末有网友开打趣提议🔥欧洲杯正规(买球)下单平台·中国官方全站,让Llama 3最初生成1千万亿点点点,就能得到AGI的权重了(狗头)。

拖累剪辑:鹿角

声明:新浪网独家稿件,未经授权阻遏转载。 -->

拖累剪辑:鹿角

声明:新浪网独家稿件,未经授权阻遏转载。 -->